GLM-5 – новая SOTA в опенсорсе и серьезная заявка от китайцев

GLM-5 – новая SOTA в опенсорсе и серьезная заявка от китайцев

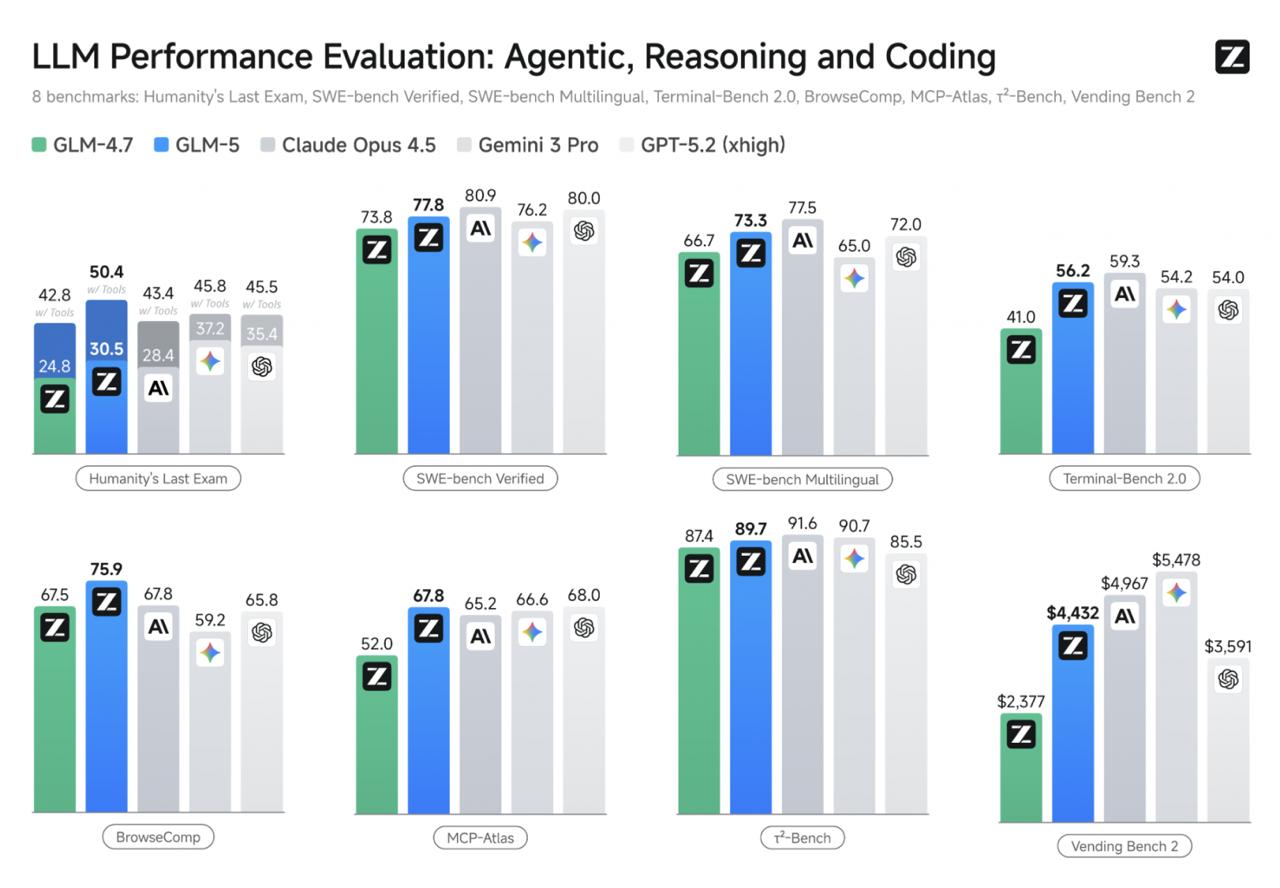

Z.ai выпустили свежую опенсорсную модель, которая тягается с Opus 4.5, Gemini 3 Pro и GPT-5.2. Предназначена она специально для кодинга, креативного письма, математики и всяких агентных задач. Пишут, что модель также очень хороша на длинных контекстах (но в релизе указано 200K токенов, так что смотря, что считать длинным).

В целом метрики очень и очень ничего. Отличный скор на HLE и SWE-bench, особенно учитывая открытые веса.

Кстати, еще одна интересная деталь: GLM-5 обучена полностью на чипах Huawei Ascend с фреймворком MindSpore, без зависимости от американского оборудования. По крайней мере, так пишут в релизе. Если правда, то это довольно серьезный прорыв для Китая во всех смыслах.

Под капотом:

– MoE 745В (44В активных). Это в два раза больше предшественницы GLM-4.5, кстати.

– 78 слоев, первые три плотные, остальные с DeepSeek Sparse Attention (DSA): как раз для эффективной работы с длинными последовательностями

– Реализован Multi-Token Prediction (MTP): модель предсказывает сразу несколько токенов за один проход форварда. В итоге скорость получается около 50+ токенов/сек, что почти в два раза быстрее предыдущего поколения.

Веса (MIT License)

Чат

Также модель доуступна в WaveSpeed API ($0.90/м input и $2.88/м output)

Вставить свои 5 копеек: