Мы 6 месяцев тестировали AI-контент против написанного людьми (SEO и GEO) —…

Мы 6 месяцев тестировали AI-контент против написанного людьми (SEO и GEO) — и результаты реально шокирующие, пишет Эндрю ван Россенберг.

В апреле этого года мы начали инвестировать в SEO и GEO.

На старте: ноль посетителей, нет блога, нет органики.

С тех пор мы проводили довольно прямолинейный тест:

— Мы написали 28 лонгридов "ручками", заточенных под очень специфические запросы нижнего этапа воронки (bottom-of-the-funnel).

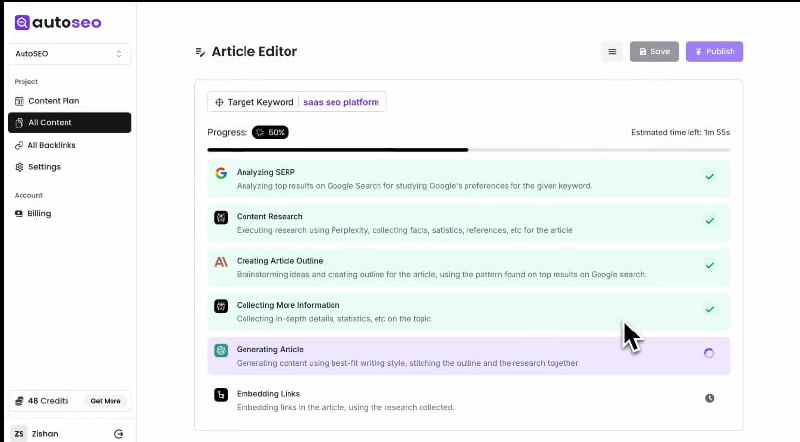

— Мы также опубликовали 192 сгенерированных ИИ поста для верхнего этапа воронки (top-of-the-funnel), используя одну тулзу (имен называть не будем).

Разница в результатах… мягко говоря, шокирует.

— Посты, написанные людьми: 722 клика и 300,154 показов.

— AI-контент? 9 кликов и 9,682 показов.

Люди, которые в итоге бронируют у нас встречи (1-3 в неделю), часто говорят, что нашли нас через LLM, и каждый раз упоминают конкретную статью — одну из тех, что написаны вручную.

Мы не уверены на 100%, что именно дает такую разницу.

— Может, качество.

— Может, то, как Гугл относится к AI-контенту.

— Может, AI-посты слишком общие (top-of-funnel).

— А может, наши рукописные статьи просто топчик.

В любом случае, ясно одно: качество все еще бьет количество.

Но хотелось бы докопаться до точной причины.

#AIContent #ContentStrategy #Experiments

@MikeBlazerX

Пушки — в @MikeBlazerPRO

Вставить свои 5 копеек: