Нейротрафик: кейсы и советы специалистов по использованию AI-контента в SEO

Рост трафика в 117 раз? Легко! Расскажу, как агентства и бренды используют AI-контент для SEO и получают постоянный трафик. А еще в статье актуальные кейсы и признаки, по которым поисковики вычисляют некачественные тексты.

Может ли текстовый AI-контент давать постоянный поток SEO-трафика? Да, если подойти к делу с умом.

Мы уже писали статью про то, как продвинуть сайт в топ с помощью AI. Однако, нейросети и алгоритмы поисковых систем не стоят на месте. Я проанализировал актуальные кейсы и мнения экспертов и снова пытаюсь ответить на вопрос, можно ли полноценный продвигать блог только на AI текстах.

В статье расскажу:

- Про возросшую важность интента

- Нужны ли люди для работы с текстами

- Как Журнал Едадила увеличил трафик в 117 раз

- Какие страницы поисковики признают качественными

Какие тексты нужны поисковикам на данный момент

Как мне кажется, лучше всего на этот вопрос ответил руководитель агентства Rush Agency Олег Шестаков. Он провел большой эксперимент на примере собственного ресурса.

В блоге Rush Agency AI-статьи размещались начиная с 2023 года. Всего было создано 25 лонгридов и 140 посадочных страниц под семантику в сфере SEO-продвижения. До весны 2024 года наблюдался устойчивый рост, а затем, Google резко снял 50 процентов трафика, распознав контент низкого качества. Редакция проекта провела работу над ошибками и уже в конце лета трафик удалось восстановить.

Вот что по этому поводу пишет руководитель агентства Олег Шестаков в своем телеграм-канале:

Что сделали? Ультимативно снесли все страницы не особо маржинальных услуг и тех услуг, которые мы реально не оказываем.

Удалили все страницы услуг, которые очень затратно переписывать и переверстывать.

Все страницы услуг, которые оставили пересмотрели с точки зрения ЦЕННОСТИ и скорости закрытия интента пользователя — тексты переписали руками, сократили страницы на 50%, удалили весь (ну почти) маркетинг.

Удалили 95% всех сгенерированных лонгридов. Оставили только те, которые зашли в ТОП и Яндекса и Google и стали приносить трафик, и еще парочку, которые можно было быстро передать так, чтобы они начали ДАВАТЬ ЦЕННОСТЬ. Пример выжившего

Поставили 20 аутрич-ссылок с хороших ресурсов. Фактически написали уникальный контент для маркетинг-изданий. Залили 20 ЦЕННЫХ статей, сделанных из моих сценариев для YouTube. Ценных не всегда = длинных и оптимизированных под какую-то семантику. Под некоторые вообще практически нет поискового спроса, но они при этом ценные. Пример ценной статьи

После этого, блог продолжают регулярно пополнять AI-статьями. Олег подчеркивает:

Да, AI-тексты могут давать классный результат, НО они должны быть ЦЕННЫМИ, ПРЯМО С ПЕРВОГО АБЗАЦА ТЕКСТА и начинать решать проблему пользователя в первые 3 секунды. Как это оценивают поисковые системы? Конечно же по поведенческим факторам.

После мартовского апдейта Google лучше вообще не делать страницы под семантику, если не можешь сделать их ценными.

Нельзя за два квартала выкладывать больше контента, чем за прошлые 2 года. Тем более сомнительного качества.

Эту же идею Олег развил в своем докладе на Optimization 2024. Вот его основные выводы:

- При создании контента должен быть фокус на полезности и уникальности. Но это не уникальность в привычном понимании данного слова, а подход к решению задачи. Копирайтеры часто переписывают друг у друга, не добавляя ничего полезного. А нужно закрыть интент пользователя уникальным образом.

- В текстах нужно использовать тематические и семантически связанные слова. Они показывают, что текст отвечает интенту пользователя. И поисковые системы это понимают.

- Обязательно нужно добавлять структурированные данные: таблицы, сравнений и выводы из личного опыта.

- Необходима обязательная проверка и редактирование AI-текстов человеком.

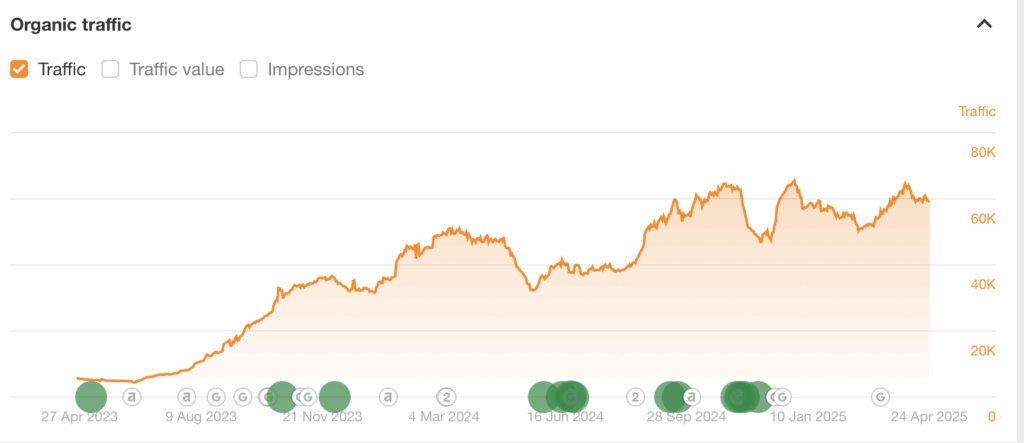

Я решил проверить, что происходит с блогом Rush Agency через год после описываемых событий. На самом деле, если не брать в расчет странный всплеск и снижение трафика в начале 2025 года, все выглядит нормально:

Результаты ресурса Rush Agency в Ahrefs

Это значит, что кейс Олега Шестакова по привлечению поискового трафика с помощью AI-статей можно считать успешным.

Итого:

- Для успешного ранжирования AI-контента в 2025 году необходимо сочетать технологии с человеческой экспертизой.

- Нужно с первых предложений отвечать на вопрос пользователя, но при этом сделать так, чтобы пользователь действительно читал статью.

- Тексты должны содержать таблицы, быть полезными и содержать тематические и семантически связанные слова.

AI-тексты как услуга

Кейс Rush Agency — не единственный на рынке. Владелец комплексного агентства MOAB Илья Исерсон активно применяет AI-тексты в рамках своего бизнеса. Его редакция делится на два отдела:

Экспертная редакция: написание лонгридов журналистского уровня, с привлечением отраслевых экспертов, спецов от бизнеса и продукта. Говоря коротко, отдел генерирует знание, которого еще нет в интернете.

Нейроредакция: написание текстов средствами ИИ. Это знание, которое есть в интернете — с корректурой, фактчекингом, связками нейронок и проч. Всем знакомые тексты на тему «как выбрать», «рейтинги», «топ 10 чего либо», рецепты, праздники, одежда и красота — все это в нормальных агентствах пишется средствами ИИ.

В своем блоге он также рассказывает о том, как это работает на практике:

- На вход поступает референс по содержанию и стилистике, набор тем и список источников для рерайта. Задача заточена под наполнение сайтов тематическими справочными текстами.

- Готовим промт под задачу. Промт-инженер выполняет: глубокий анализ текста-референса, адаптацию результатов анализа для промта, тестирование, стабилизацию, корректировку промта, если есть дополнительные требования.

- Готовим исходники. Проводится либо парсинг большого массива, либо сбор урлов под задачу.

- Генерим тексты. Маршрут простой: суем исходник + промт в ИИ, получаем результат, проверяем на антиплагиате, чекаем живым редактором и оформляем на сдачу.

По похожему алгоритму происходит генерация небольших текстов:

Также Илья делится алгоритмом для генерации лонгридов в нейроредкции:

На подготовку связки промтов, их тестирование и стабилизацию промт-инженер тратит 10-12 часов.

Тут используется различный инструментарий и ИИ:

- Сбор подсветки.

- (ИИ) Сбор слов, задающих тематику.

- Сбор и (ИИ) анализ ТОПа выдачи.

- (ИИ) Выяснение нужного объема текста.

- Сбор LSI из Релевантуса.

- (ИИ) Составление развернутой структуры текста с комментариями для каждого раздела и указанным объемом каждого раздела.

- (ИИ) Составление портрета ЦА.

- (ИИ) Глубинная аналитика референсных текстов с составлением стилистических рекомендаций.

- Оптимизация промта под специфические требования заказчика.

- (ИИ) Сбор фактажа для статей (для специфичных тем типа биографий).

- Генерация текста.

- Доработка с т.з. оптимизации, ширины и глубины облака, уникальности.

- Проверка по SEO-метрикам типа тошноты/процента по слову и так далее.

- Вычитка живым редактором.

- Опционально в сложных темах — фактчек нейросетью.

Примеры: пример 1, пример 2, пример 3

Основная рабочая лошадка для подготовки — ChatGPT-4o, для генерации — Claude Sonnet 3.5, в фактчекинге хорош Gemini 2.0 Flash.

Как все это работает? Кажется, что довольно круто.

В конце 2024 года в рунете прогремел кейс Журнала Едадил, контент для которого делало агентство MOAB. Рост проекта составил 117 раз (с 5019 визитов в апреле 2023 до 589 643 визитов в октябре 2024). Особенно забавно, что сейчас Едадил — это проект Яндекса, который периодически грозит пальцем по поводу AI -контента.

На момент написания кейса было опубликовано 316 «человеческих» статей и 413 текстов, которые сгенерили нейросетью, то есть ключевым фактором успеха стала комбинация AI-контента и человеческой редакции.

Темы подбирались на основе семантического анализа, частотности запросов и сезонности. Нейросети использовались для генерации черновиков (особенно для объемных и структурированных текстов). Однако все материалы проходили обязательную вычитку и правку редакторами для устранения ошибок и повышения качества. Благодаря технической оптимизации и подбору актуальных тем, статьи (в том числе AI-сгенерированные) регулярно попадали в Google Discover, обеспечивая краткосрочные, но значительные всплески трафика.

Этот ресурс я тоже проверил в Ahrefs. Проект лихорадит, но, в целом, рост органического трафика продолжается. Как и в кейсе Rush Agency, можно видеть сильную просадку в апреле 2024 года. Далее идет снижение в конце 2025 года и зимняя коррекция.

Журнал Едадила в Ahrefs

Как и в случае с Rush Agency, кейс демонстрирует, что успешная стратегия контент-маркетинга в 2025 году требует баланса между автоматизацией и человеческим контролем.

AI-тексты в арбитраже

Наверное, этот блок можно наполнить безграничным количеством кейсов, потому что большинство аффилейт-сайтов сейчас запускаются на AI-текстах.

Подробнее про это читайте в интервью c руководителем SEO-команды Citadel.

Но в этой статье я хочу рассказать именно о сравнительно крупных проектах с большим количеством трафика.

На аффилейт-форуме KINZA Алексей Seo Nomad (руководитель команды SEO Dream Team) поделился успешными кейсами продвижения сайтов с AI-контентом. Его проекты достигли тысяч посещений в сутки при минимальных бюджетах.

Например, в апреле 2024 года команда запустила сайт-каталог моделей OnlyFans, полностью сгенерированный нейросетью. Семантика собиралась через шаблоны в Ahrefs: название модели + хвостовые запросы. ИИ создавал описания, и для низкочастотных запросов их оказалось вполне достаточно для топовых позиций.

Сайт вышел из «песочницы» Google за 3 месяца, достигнув 8000 переходов в сутки. Внутренняя структура усилила вес страниц: тысячи товарных листингов ссылались на категории, а те — на главную. Никаких внешних ссылок не использовалось. Несмотря на DDoS-атаки и DMCA-жалобы конкурентов, трафик оставался стабильным.

Алексей выделил несколько важных рекомендаций:

- оптимальный объем контента — от 1000 до 3000 символов без пробелов,

- для ускорения индексации сайта команда использовала собственный скрипт, автоматизирующий обход sitemap вместо стандартных инструментов вроде Google Index API,

- чтобы обходить агрегаторы в поисковой выдаче, он рекомендовал фокусироваться на узкой экспертизе — например, создавать сайты с тысячами страниц по одной конкретной теме,

- в целом, ИИ-инструменты вроде ChatGPT и Vsesvit AI вполне эффективны в плане генерации контента, но для высокочастотных запросов критически важно делать уникальный и экспертный материал.

Итого:

- Масштабирование контента и грамотное использование ИИ позволяют обходить конкурентов даже с минимальным бюджетом.

- Ключевые факторы — автоматизация, внутренняя перелинковка и фокус на низкочастотные запросы.

- Экспертность и уникальность остаются критичными для высокочастотных запросов и устойчивости к алгоритмам Google.

Как генерировать тексты в 2025 году

Более подробно про принципы работы с AI-текстами можно прочитать в презентации Катерины Ерошиной, главного редактора агентства MOAB.

Ниже краткая выжимка по алгоритму работы ее нейроредакции.

Экспертные и нишевые материалы, где нужна глубокая аналитика или свежие данные, пока остаются за людьми. ИИ эффективен в создании SEO-контента, который ориентирован на роботов, а не на живых читателей: это тексты для трафика, ссылок или технических заданий с большими объемами и низким порогом качества. Однако в случаях, где требуется нешаблонная логика, B2B-экспертиза или работа с уникальными нишами, ИИ не справится без человеческого контроля.

Основной инструмент (на момент создания презентации) — ChatGPT 4.0/4o, но у него есть ограничения: он забывчив, склонен к переспаму, не умеет вставлять анкоры и генерировать длинные тексты без пошагового руководства. Claude, хотя и креативнее в рерайтинге, не рассматривается как основное решение.

Процесс работы делится на два формата: для коротких материалов и лонгридов. Для коротких текстов (до 2500 знаков) достаточно сгенерировать метатеги, создать контент по шаблону, добавить ссылки и картинки, после чего проверить результат редактором. Длинные статьи (12 — 15 тыс. знаков) требуют подготовки структуры на основе семантики, разбивки на блоки и пошаговой генерации с постоянным контролем ключей, фактов и стиля.

Ключевой элемент успеха — промпты. Они должны включать роль (не просто «копирайтер», а узкая специализация), контекст (аудитория, цель), четкие требования и примеры текстов. Например, для анализа структуры конкурентов подойдет запрос: «Проанализируй статьи по ссылкам [X], выдели заголовки, предложи структуру для запроса [Y]». Важно использовать отдельные чаты для разных задач, постоянно напоминать ИИ правила и корректировать его в процессе: «В пункте [X] добавь статистику, оформи список».

Очень важен контроль качества. Каждый текст проверяют на соответствие ТЗ, водность, уникальность и ключи. ИИ может искажать факты, поэтому данные перепроверяют вручную. Генерация изображений, вопреки ожиданиям, увеличивает время подбора визуала втрое. Итоговый текст всегда проходит SEO-анализ и редактуру.

Главный вывод — ИИ все еще лишь инструмент, а не замена автора. Он экономит время на шаблонных задачах, но требует экспертного подхода. Лучшие результаты достигаются, когда над текстами работают сильные редакторы и SEO-специалисты, способные составлять точные промпты и корректировать ошибки. Например, для статьи о выборе бензогенератора промпт может звучать так: «Ты — инженер с навыками писателя. Напиши 12 тыс. символов, используя ключи [X], без продажников». Важно избегать фантазий, дробить задачу на этапы и напоминать ИИ о цели: помочь читателю, а не продать товар.

Массовая генерация ИИ-текстов возможна, но только при условии продуманной стратегии, контроля качества и понимания рисков. Как отмечает Катерина Ерошина, ИИ — это «зеркало»: он пишет настолько хорошо, насколько компетентен тот, кто им управляет.

Почему это важно?

Развеиваем иллюзии: по кейсам видно, что, несмотря на развитие нейросетей, в 2025 году создавать экспертный контент без участия человека все еще невозможно. Живая редактура и вычитка нужны абсолютному большинству полноценных текстов для медиа и только в ситуациях, когда нужно много простого контента (простые iGaming-сайты, сайты-агрегаторы и т. д.) AI-тексты хорошо справляются с задачей даже без глубокой редактуры.

В то же время, с помощью AI-текстов и опытного редактора можно достаточно быстро нарастить количество контента на своих площадках. Несмотря на все противоположные заявления поисковых систем, доля AI-контента в выдаче только растет — это доказывают наши примеры, журнал Едадила и блог Rush Agency.

Основные рекомендации на 2025 год:

- Особое значение для хорошего ранжирования текста приобретают слова из тематики и NLP LSI.

- В сравнении с Яндексом, Google требует больше точных вхождений и плотности ключевых слов, но менее требователен к объему текста. Яндекс лучше отличает «воду» от полезного контента.

- Статья должна предлагать уникальное решение проблемы пользователя, с которой он пришел на страницу и учитывать интент.

FAQ

Поисковики ранжируют AI-контент?

В чем секрет хорошего ранжирования?

Как добавлять AI-контент на свой сайт?

Какие страницы «плохие» в глазах поисковиков?

Материалы по теме

Вставить свои 5 копеек:

Тяжелый текст и шрифт для чтения

Если Google стал так строго реагировать на неценный ии контент, то как тогда заранее понять, какие тексты «закроют интент» и не попадут под фильтр? Мб есть какие-то чек-листы ?

И еще. В кейсе OnlyFans-сайта трафик пришёл на низкочастотные запросы. А как быть с высокочастотными и как тогда понять, когда нужен человек а когда можно обойтись только ИИ?